NOTRE ACTIVITE DE CONSEIL EN ETHIQUE DES DISPOSITIFS IA

Souvent invisibles, les algorithmes prennent une place de plus en plus importante au sein des entreprises, des services publics et dans notre quotidien.

Cela comprend notamment les relations commerciales avec les algorithmes décisionnels, le marketing et la communication avec les agents conversationnels et les publicités ciblées, le médical avec les diagnostics médicaux automatisés ou encore l’éducation avec les algorithmes d’évaluation et de sélection des candidatures.

Déléguer son pouvoir à un algorithme peut entraîner des risques touchant les droits fondamentaux, la santé et la sécurité.

Plus les IA progressent et plus ces questions prennent de l’importance. Ce phénomène s’accélère et nous invite à faire preuve de prudence sur l’utilisation des algorithmes. La question d’un recours éthique de l’IA réclame des réponses urgentes.

L’éthique peut être définie globalement comme un dispositif qui établit les valeurs d’une entreprise ainsi que les principes, les missions et les lignes de conduite de chaque corps de métier.

Mais chaque secteur d’activité et chaque métier va devoir décliner ces valeurs selon ses propres spécificités afin d’éviter des risques de pénalisation, d’exclusion, de discrimination ou d’intrusion dans notre vie privée.

Des biais peuvent survenir comme les biais cognitifs, conséquence des préjugés éventuels des concepteurs à l’origine des algorithmes ou les biais statistiques si les données utilisées pour concevoir et tester un algorithme ne sont pas représentatives de la réalité.

Le phénomène de boite noire s’amplifie avec, d’une part, le développement des nouvelles architectures de stockage et de traitement de données massives (Big data), et d’autre part, l’évolution des algorithmes de Deep Learning de plus en plus complexes.

Les réseaux de neurones profonds ont vu leur nombre de paramètres croître de manière exponentielle.

Nous vous aidons à identifier les risques liés à chaque type d’algorithme et à son système d’information sous-jacent et comment les réduire par la mise en place des dispositifs suivants

Une gouvernance de la donnée adaptée : un ensemble de dispositifs de gestion des données (préparation, évaluation) doivent être déployés pour assurer la qualité, la disponibilité et la conformité des données.

Une documentation technique : établie avant la mise sur le marché ou la mise en service d’un système d’IA, et mise à jour en continue, elle doit décrire de manière détaillée le système et celui en place pour évaluer ses performances.

Un système de gestion des risques en continu : un processus itératif continu d’identification, d’évaluation des risques (des biais) et de tests des mesures de remédiation doit être exécuté tout au long du cycle de vie du système.

Une traçabilité permanente : les systèmes d’IA doivent disposer d’un enregistrement automatique d’évènements (« logs ») permettant de tracer toute utilisation, intervention ou modification.

Une transparence et une information utilisateur : les systèmes d’IA doivent être conçus de manière à ce que leur fonctionnement soit transparent pour permettre aux utilisateurs d’interpréter les résultats du système et de les utiliser.

Une surveillance humaine : les systèmes d’IA doivent être surveillés par des personnes physiques via une interface permettant de détecter les anomalies, d’intervenir, voir de stopper le système afin de prévenir les risques.

Un système précis, robuste et sécurisé : les systèmes d’IA doivent atteindre un niveau approprié de prévision, de robustesse et de cybersécurité pour être résilients face aux erreurs et aux tentatives de tiers non autorisés.

L’IA ACT, Règlement européen sur l’Intelligence Artificielle

L’IA est aujourd’hui imparfaitement régulée dans le Monde. L’arrivée des IA génératives renforce le besoin de régulation. Un nouveau dispositif de réglementation, l’IA Act, a donc vu le jour en Europe. Cet IA Act a en effet été adopté le 08 décembre 2023. Des réunions techniques ont lieu afin d’affiner son exécution. En cas de non-conformité, l’amende peut aller jusqu’à 7 % du chiffre d’affaires ou 35 millions d’euros.

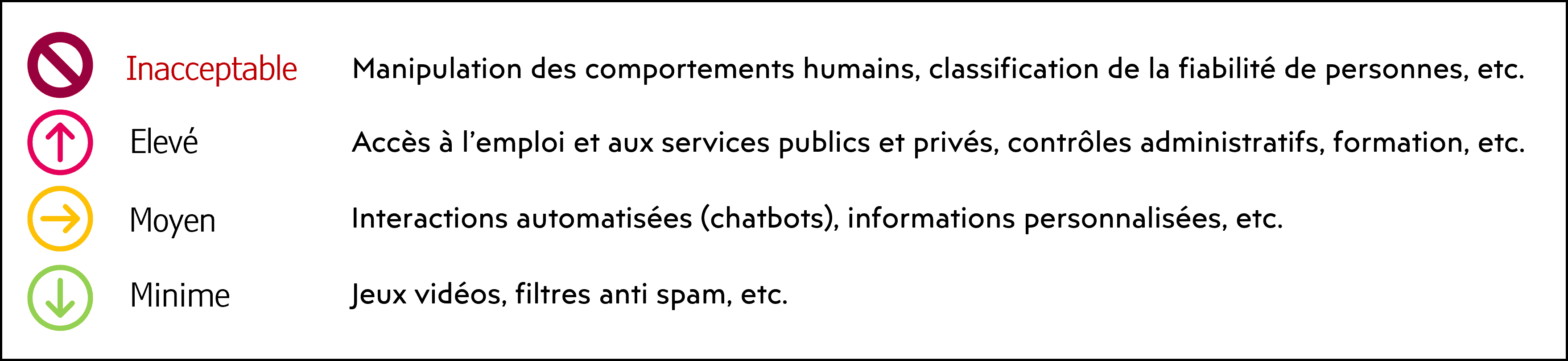

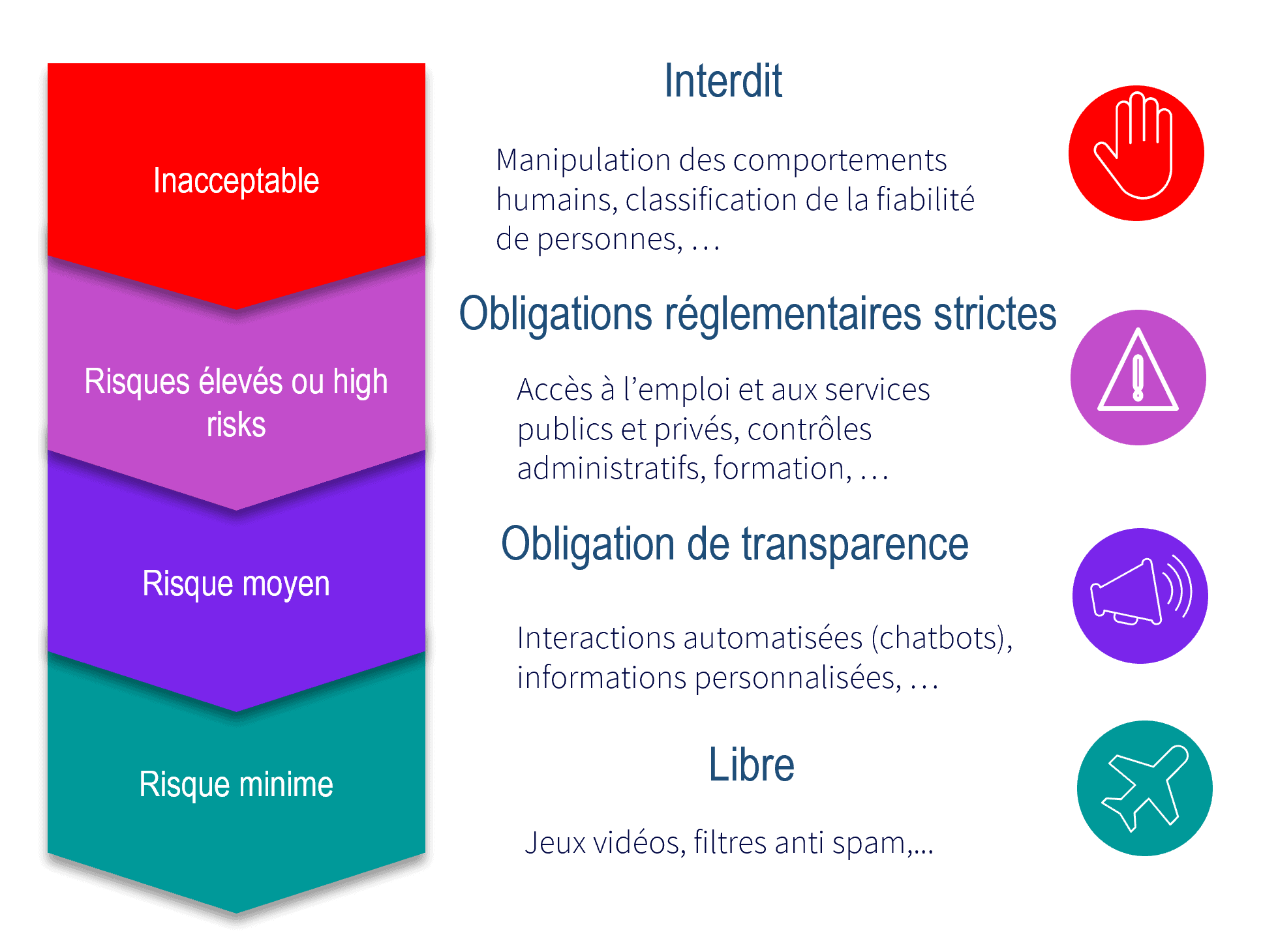

L’IA Act adapte la réglementation en fonction de la gravité des risques. On distingue 4 niveaux de risques :

Une cinquième catégorie a été rajoutée sur les IA Génératives :

- Indiquer que le contenu a été généré par une IA.

- Aider à distinguer les vrais images des fausses.

- Présenter des garantis contre la génération de contenus illicites.

- Publier des résumés des données protégées par le droit d’auteur, utilisés pour la formation du modèle.

- Nous cartographions les risques dans votre organisation.

- Nous vous aidons à identifier les algorithmes en risques élevés.

- Nous vous accompagnons pour que chaque algorithme en risque élevé vérifie les conformités exigées par le règlement européen.

- Nous réalisons avec vous la procédure de marquage CE auprès des autorités de régulation.

Nos points forts :

- Expertise juridique via notre cabinet d’avocats partenaire.

- Expertise en IA, notre ADN.

- Suivi permanent des amendements et des conclusions (Conseil, Commissions exécutives et techniques, parlement) depuis la parution du premier texte.

- Conception d’un outil d’évaluation des conformités des risques élevés.

- Mise en place d’une formation sur l’IA Act pour le personnel directement impliqué ou impacté.

Plus de détails sur L’IA ACT

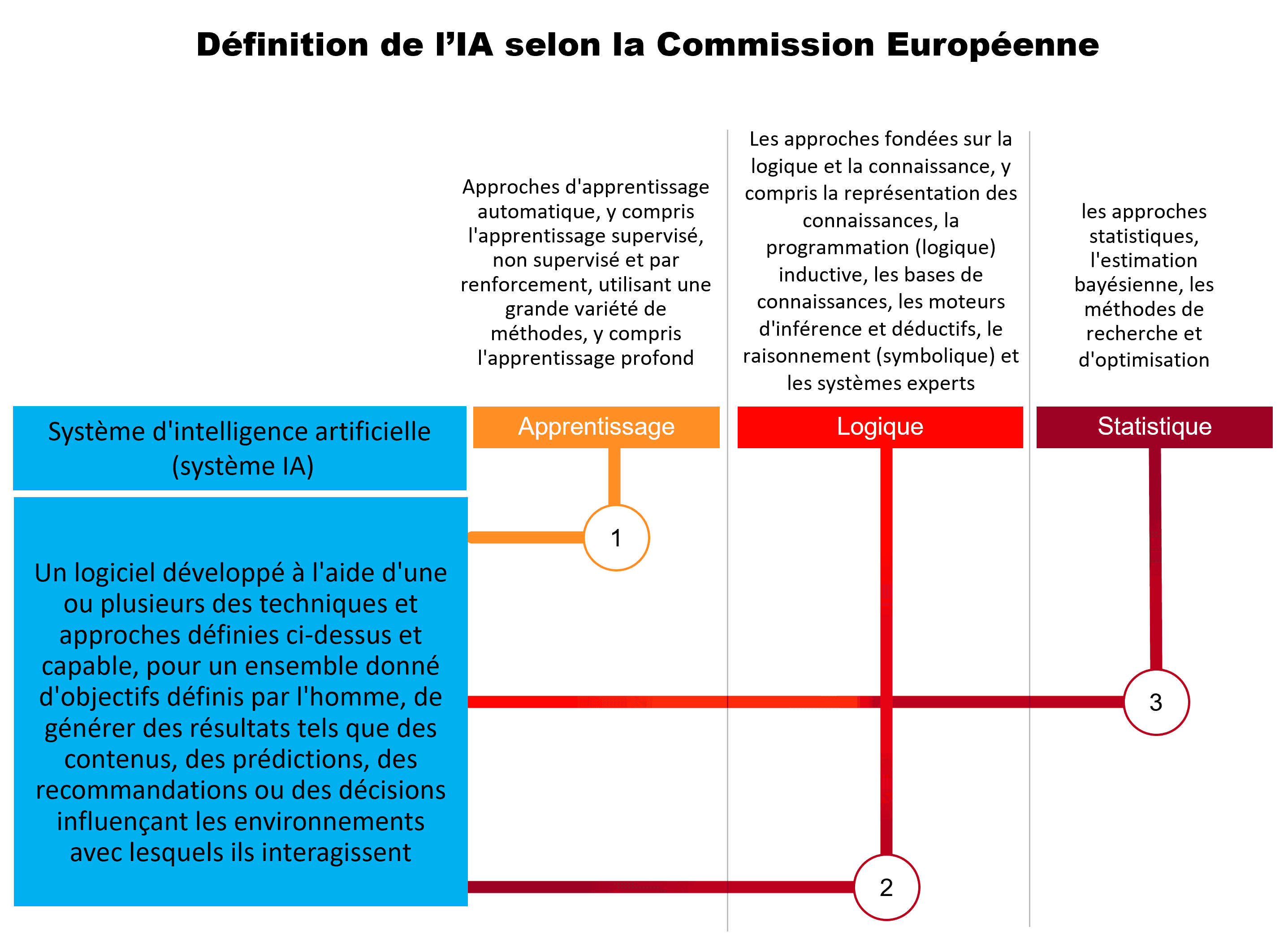

Les progrès effectués dans les capacités de stockage d’informations composites et dans la puissance de calcul permettent aux algorithmes d’Intelligence artificielle (IA) de réaliser des prouesses : interprétation des images, moyens de transport autonomes, diagnostics médicaux automatisés, robots multi-tâches, plateformes marketing intelligentes, enceintes connectées, gestion de plus en plus fine des relations entre l’humain et la machine.

L’IA apporte des avantages économiques et sociétaux, mais entraîne également de nouveaux risques pour les individus quant à leurs droits fondamentaux, leur santé et leur sécurité.

L’IA Act est une réglementation européenne dont l’objectif est de réduire les risques sans entraver le développement technologique et l’innovation.

Rappel des éléments clés du règlement IA ACT

L’objectif de l’IA Act est de faire en sorte que les systèmes d’IA mis sur le marché européen respectent les droits fondamentaux des citoyens et les valeurs de l’UE en veillant à ce qu’ils soient sûrs, transparents, éthiques, impartiaux et sous contrôle humain.

La mise en œuvre de cette réglementation doit permettre de faciliter le développement d’un marché unique pour les applications d’IA légales et dignes de confiance et de prévenir la fragmentation du marché qui pourrait survenir du fait de cadres nationaux potentiellement contradictoires empêchant la libre circulation des biens et services intégrant l’IA.

Outre l’interdiction de certaines pratiques contraires aux valeurs de l’UE, l’IA Act impose des obligations proportionnées au niveau de risque des systèmes vis-à-vis de leurs usages. En particulier, ceux à risque élevé doivent obtenir un marquage CE et être enregistrés dans une base de données de l’UE.

Le principe de proportionnalité des risques

La Commission propose de nouvelles règles pour veiller à ce que les systèmes d’IA utilisés dans l’UE soient sûrs, transparents, éthiques, impartiaux et sous contrôle humain. Ces systèmes sont donc classés en fonction de leur niveau de risque :

Les risques inacceptables

1 — Mise sur le marché, mise en service ou utilisation d’un système d’IA qui déploie des techniques subliminales au-delà de la conscience d’une personne dans le but ou avec l’effet de déformer matériellement le comportement d’une personne d’une manière qui cause ou est raisonnablement susceptible de causer à cette personne ou à une autre un préjudice physique ou psychologique.

Exemple : Envoi d’une information biaisée en vue d’orienter un vote.

2 — Mise sur le marché, mise en service ou utilisation d’un système d’IA qui exploite l’une des vulnérabilités d’un groupe spécifique de personnes en raison de leur âge, de leur handicap ou d’une situation sociale ou économique particulière, avec pour objectif ou pour effet de fausser sensiblement le comportement d’une personne appartenant à ce groupe d’une manière qui cause ou est raisonnablement susceptible de causer à cette personne ou à une autre un préjudice physique ou psychologique.

Exemple : discrimination implicite par l’adresse qui a pour effet de pénaliser l’accès au crédit pour des Français d’origine étrangère.

3 — Mise sur le marché, mise en service ou utilisation de systèmes d’IA pour l’évaluation ou la classification de personnes physiques pendant une certaine période sur la base de leur comportement social ou de caractéristiques personnelles ou de personnalité connues ou prévues, le score social conduisant à l’un ou l’autre des éléments suivants, ou aux deux :

(i) un traitement préjudiciable ou défavorable de certaines personnes physiques ou de certains groupes de personnes physiques dans des contextes sociaux sans rapport avec les contextes dans lesquels les données ont été initialement générées ou collectées.

Exemple : refus d’un service public en raison d’une altercation antérieure avec un conducteur de bus.

(ii) un traitement préjudiciable ou défavorable de certaines personnes physiques ou de certains groupes de personnes physiques qui est injustifié ou disproportionné par rapport à leur comportement social ou à sa gravité.

Exemple : convocation policière suite à l’absence de masque durant le Covid.

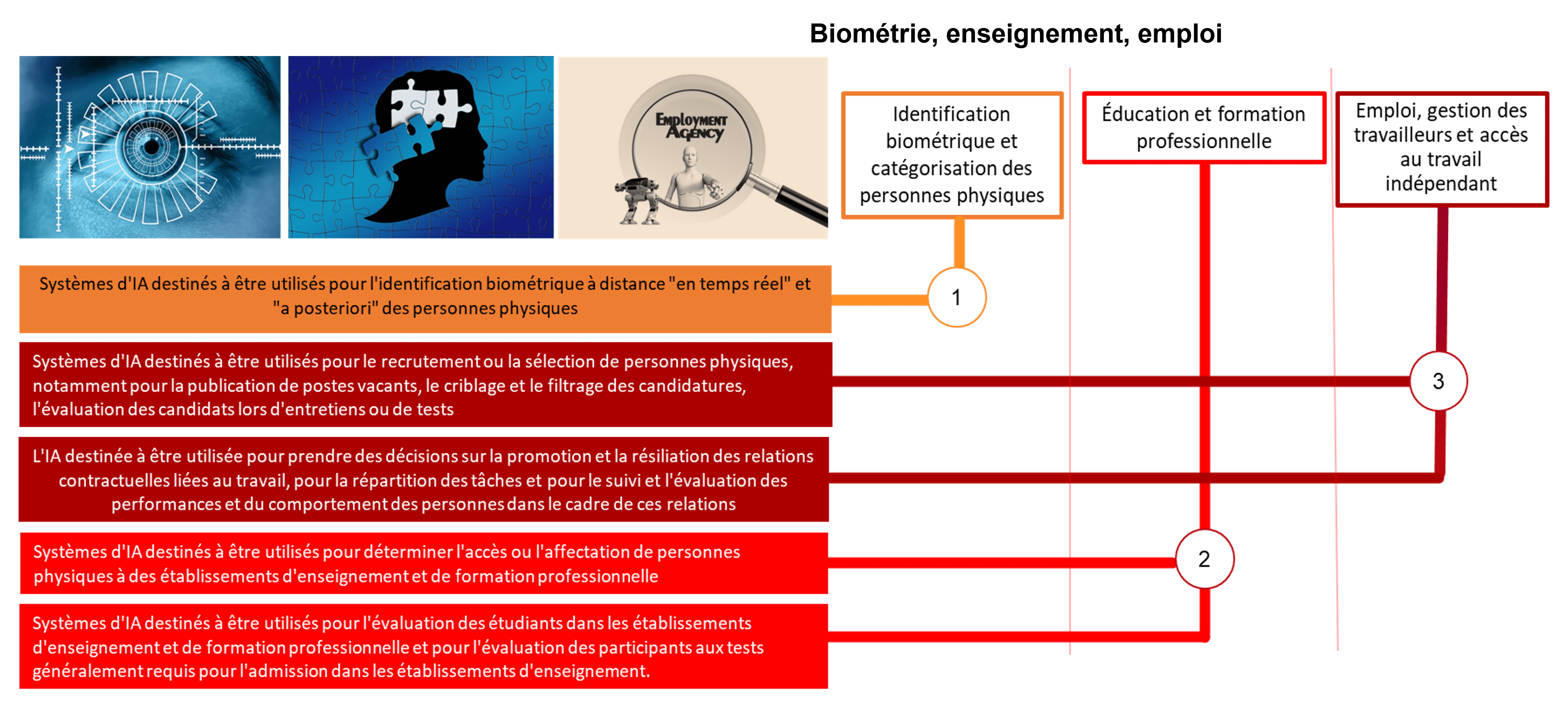

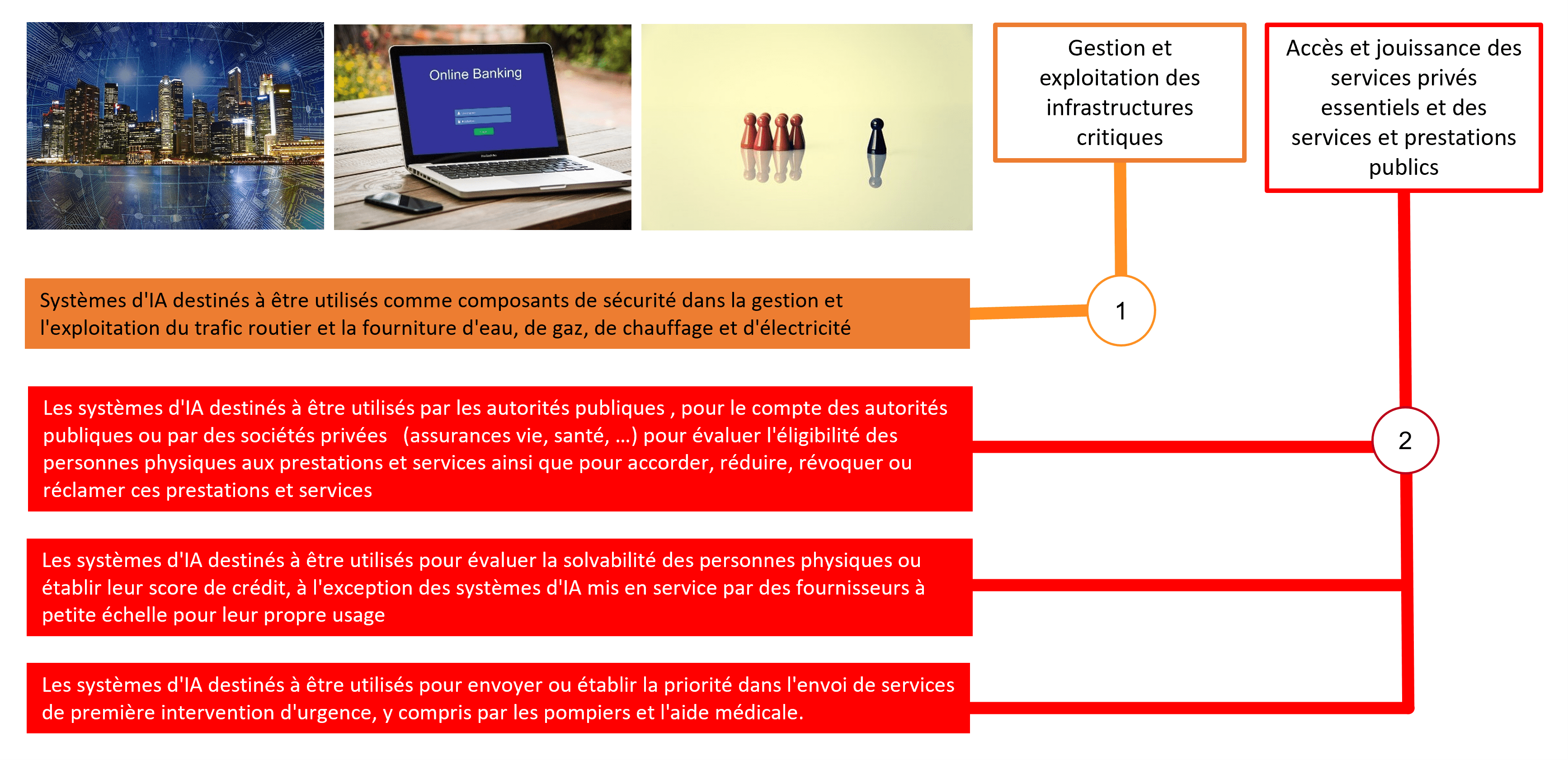

Exemples de risques élevés

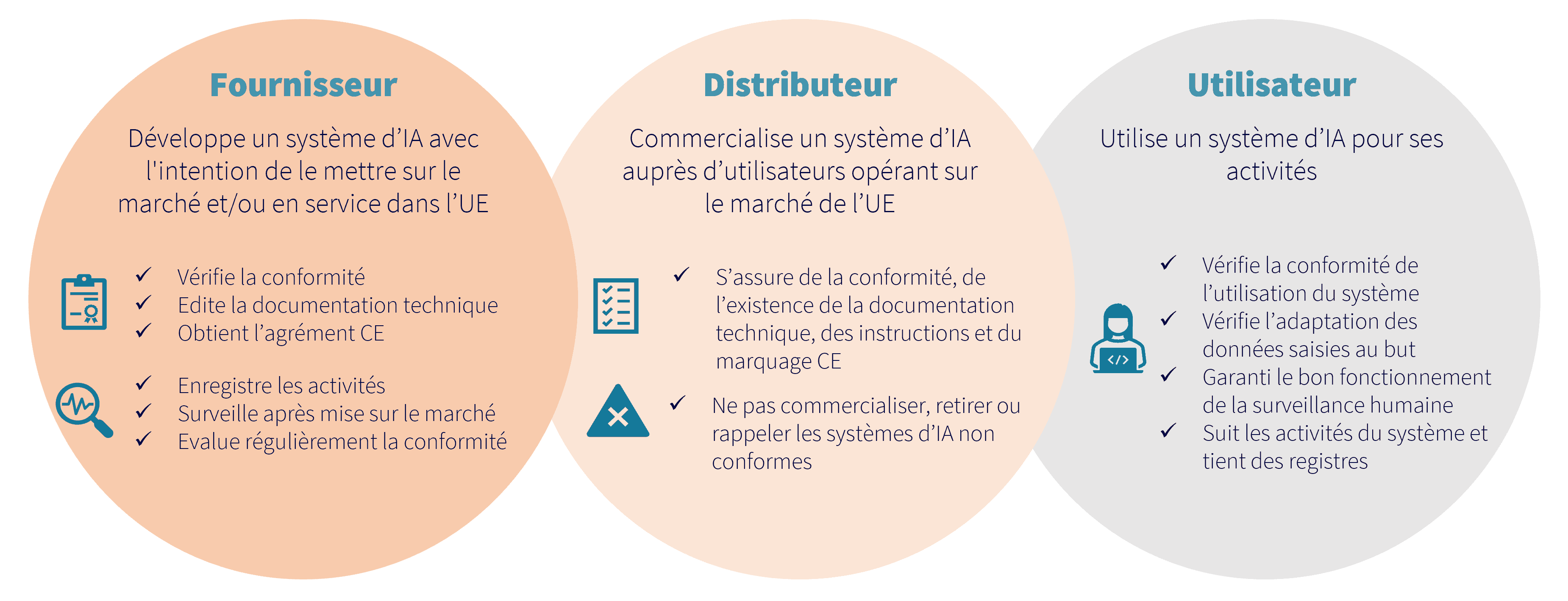

Qui est concerné ?

- Tout organisme à l’intérieur et à l’extérieur de l’UE qui fournit un système d’IA à destination et/ou qui impacte des individus dans l’UE.

- Tout Fournisseurs/Importateurs/Distributeurs d’un système d’IA au sein de l’UE.

- Tout utilisateur de systèmes d’IA au sein de l’UE.

- Tout fournisseur ou utilisateur situé dans un pays tiers, mais dont le résultat produit par le système d’IA est utilisé dans l’UE.

En fonction de sa position dans la chaîne de distribution et de mise en œuvre du système, les obligations diffèrent :